Большие модели логического вывода не справляются с выполнением инструкций во время логического вывода: сравнительное исследование

От изучения исследовательских идей до создания крупномасштабных программных систем и принятия обоснованных решений — большие модели рассуждений (LRM), которые генерируют пошаговые цепочки рассуждений между специальными тегами (например, … в моделях семейства DeepSeek и <|канал|>анализ<|сообщение|>…<|конец|> в моделях семейства GPT-OSS) быстро завоевали популярность. Их способность к логическому мышлению не только повышает интерпретируемость, но и позволяет проводить итеративную доработку, что делает LLM-модели высокоэффективными в задачах, требующих тщательного анализа. Мы в Together AI очень рады всплеску интереса к LLM-моделям на всех этапах жизненного цикла ИИ, но ключевой вопрос остается открытым:

Следуют ли эти высокоэффективные модели инструкциям пользователя в процессе рассуждений?

Следование инструкциям пользователя на протяжении всего процесса обработки данных, а не только при получении окончательного ответа, повышает управляемость, прозрачность и безопасность.

- Следование инструкциям на уровне процесса делает взаимодействие более предсказуемым и ориентированным на пользователя, позволяя пользователям управлять тем, как модель мыслит, а не только тем, что она выдаёт.

- Структурированные логические цепочки (например, шаги в формате JSON, приведённые доказательства) позволяют проводить программный аудит логики и соответствия требованиям.

- Последовательное соблюдение инструкций по логическому мышлению помогает предотвратить взлом системы вознаграждения и использование коротких путей, которые приводят к внешне правильным ответам.

- Точное следование инструкциям по логическому мышлению также более устойчиво к манипуляциям со стороны злоумышленников, поскольку внутренние шаги модели ограничены явными правилами, заданными пользователем.

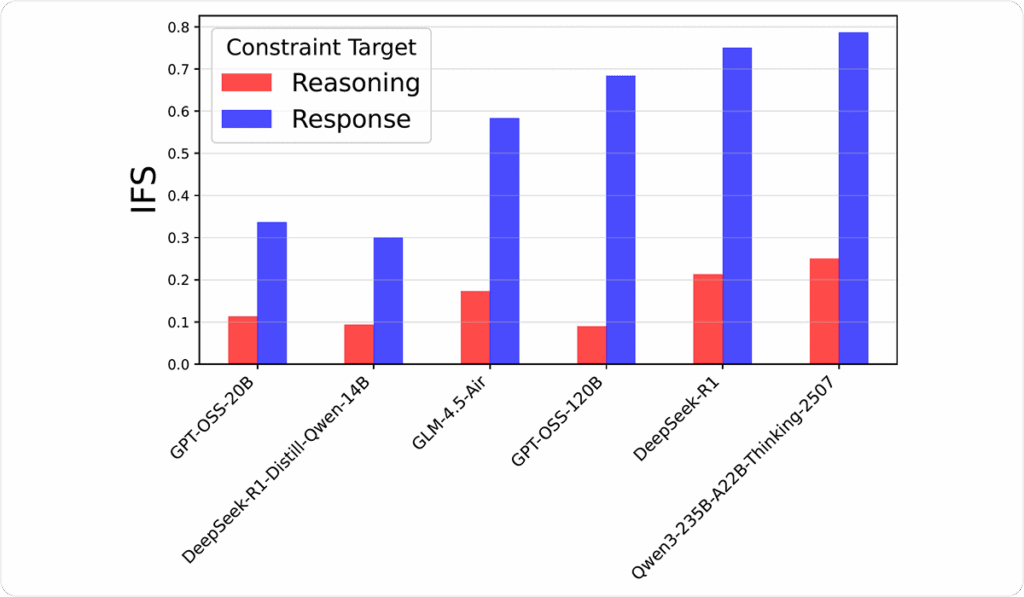

Руководствуясь этими соображениями, мы вводим новый критерий и оцениваем, насколько точно LRM следуют инструкциям при создании логических цепочек. Наши основные выводы: хотя модели в целом дают правильные ответы, они гораздо чаще ошибаются в своих логических рассуждениях, и этот недостаток усугубляется по мере усложнения задачи.

2. ReasonIF: новый набор эталонных данных

Чтобы продвинуться в этой области, мы представляем ReasonIF — новый набор данных для тестирования, предназначенный для оценки способности следовать инструкциям в рамках логических цепочек. ReasonIF состоит из 300 математических и научных задач, каждая из которых сопровождается конкретной инструкцией по логическому мышлению. Каждое вводное сообщение состоит из двух компонентов.

- Вопрос, взятый из авторитетных коллекций тестов (GSM8K, AMC, AIME, GPQA‑diamond и ARC‑Challenge), обеспечивает широкий спектр стилей рассуждения.

- Инструкция, выбранная случайным образом из набора из шести ориентированных на пользователя директив, которым модель должна следовать на протяжении всего пошагового решения.

Вслед за предыдущей работой IFEval (Чжоу и др., 2023), в которой изучались общие возможности больших языковых моделей по выполнению инструкций, мы используем проверяемые инструкции, которые можно автоматически оценить без привлечения другой большой языковой модели. Однако, в отличие от IFEval, мы сосредоточились на самом процессе рассуждения. Шесть типов инструкций разработаны с учётом реальных потребностей пользователей, что позволяет точно и автоматически проверять, соответствует ли модель заданным инструкциям.

- Многоязычность: Ограничивает рассуждения определённым языком (например, хинди, арабским).

- Ограничение по количеству слов: Сокращает объём текста для экономии ресурсов и повышения лаконичности.

- Отказ от ответственности: Добавляет в конец напоминание о безопасности.

- Форматирование в формате JSON: Обеспечивает структурированный, машиночитаемый вывод.

- Только заглавные буквы: Обеспечивает строгое форматирование и детальный синтаксический контроль.

- Убрать запятые: Аналогично параметру «Только заглавные буквы».

Вот несколько показательных примеров из нашего эталонного набора данных:

Редактор: AndreyEx