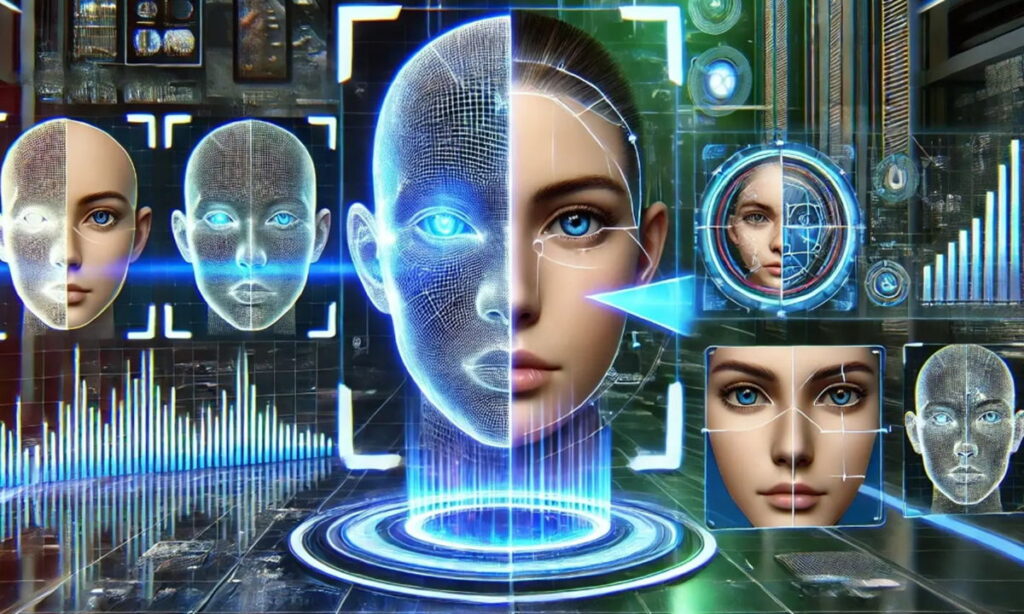

Дипфейки 2026 года сделают невозможным различение реальности

Появление дешевых, доступных и мощных инструментов искусственного интеллекта позволило манипулировать цифровым аудио, видео и графическим контентом способами, неизвестными на сегодняшний день. Это явление только началось, и некоторые исследователи предупреждают о его экспоненциальном увеличении возможностей, объема и потенциала для кибератак. Проще говоря, дипфейки 2026 года сделают невозможным отличить реальность от вымысла.

Глубокие фейки были — наряду с программами-вымогателями — основными кибератаками 2024 года, и в этом году они значительно «улучшились». Качество созданных искусственным интеллектом лиц, голосов и изображений в полный рост, имитирующих реальных людей, намного превзошло ожидания экспертов. Кроме того, они все чаще использовались для обмана пользователей.

Во многих повседневных ситуациях, особенно при видеозвонках с низким разрешением и обмене мультимедийным контентом в социальных сетях, его реалистичность теперь достаточно высока, чтобы надежно ввести в заблуждение неопытных зрителей. На практике синтетические носители информации стали неотличимы от подлинных записей для обычных людей, а в некоторых случаях даже для предприятий и учреждений.

Это увеличение не ограничивается качеством разработок. Объем дипфейков вырос в геометрической прогрессии: по оценкам компании DeepStrike, занимающейся кибербезопасностью, с примерно 500 000 онлайн-фейков в 2023 году он увеличился примерно до 8 миллионов в 2025 году, при этом ежегодный рост приближается к 900%. Столкнувшись с ними и несмотря на сообщения, в которых подчеркивается угроза, которую порождающий ИИ представляет для цифровой реальности, и предложения многоуровневых защитных структур, был достигнут очень незначительный прогресс.

Один из авторов отчета, профессор компьютерных наук и директор Лаборатории судебной экспертизы СМИ в Университете Буффало, опубликовал ситуационный анализ, в котором прогнозируется ужасный наступающий год, когда большинство не сможет отличить законный контент.

Впечатляющие «улучшения» в дипфейках

В основе этой резкой эскалации лежит несколько технических изменений. Во-первых, реализм видео значительно вырос благодаря моделям генерации видео, специально разработанным для обеспечения согласованности во времени . Эти модели создают видеоролики с последовательным движением, последовательной идентичностью изображаемых людей и последовательным контентом от кадра к кадру. Модели отделяют информацию, относящуюся к представлению личности человека, от информации о движении, так что одно и то же движение может быть сопоставлено с разными идентификаторами. Или одна и та же личность может иметь несколько типов движений.

Эти модели создают стабильные, целостные лица без мерцания, деформаций или структурных искажений вокруг глаз и челюсти, которые когда-то служили надежными судебно-медицинскими доказательствами дипфейков.

Во-вторых, клонирование голоса перешагнуло то, что эксперт называет «неразличимым порогом». Теперь достаточно нескольких секунд звука, чтобы создать убедительное клонирование с естественными интонациями, ритмом, акцентом, эмоциями, паузами и шумом дыхания. Эта возможность уже способствует крупномасштабному мошенничеству. Некоторые крупные розничные торговцы сообщают о получении более 1000 мошеннических звонков с использованием искусственного интеллекта в день. Перцептивные сигналы, которые раньше выдавали синтетические голоса, практически исчезли.

В-третьих, потребительские инструменты снизили технический барьер практически до нуля. Появление улучшенных приложений искусственного интеллекта, таких как OpenAI Sora 2 или Google Seo 3, в сочетании с появлением множества стартапов позволяют любому описать идею, позволить обширной языковой модели, такой как OpenAI ChatGPT или Google Gemini, написать сценарий и создавать высококачественный аудиовизуальный контент за считанные минуты. Агенты искусственного интеллекта могут автоматизировать весь процесс. Способность генерировать последовательные и основанные на аргументах глубокие фейки в широком масштабе была эффективно демократизирована.

Такое сочетание растущего количества и персонажей, почти неотличимых от реальных людей, создает серьезные проблемы для обнаружения дипфейков, особенно в среде СМИ, где внимание людей фрагментировано, а контент распространяется с большей скоростью, чем это можно проверить. И поступает множество сообщений о реальном ущербе — дезинформации, преследованиях, финансовых махинациях и практически любых кибератаках, — как только глубокие фейки с использованием искусственного интеллекта перестанут быть теоретической функцией и превратятся в «решение», которое можно использовать в реальном мире. подрывает доверие к цифровым технологиям, подвергает компании новым рискам. риски и стимулы для коммерческого бизнеса киберпреступников.

Дипфейки 2026 года: неразличимые и в реальном времени

Исследователь продвигает будущее, в котором глубокие фейки продвигаются к синтезу в реальном времени, способному создавать видео, напоминающие нюансы человеческого облика, что облегчит их уклонение от систем обнаружения. Граница переходит от статического визуального реализма к временной и поведенческой согласованности — моделям, которые генерируют контент в прямом или почти прямом эфире, а не предварительно отрендеренные клипы.

Моделирование идентичности объединяется в унифицированные системы, которые фиксируют не только внешний вид человека, но и то, как он двигается, звучит и говорит в различных контекстах. Результат варьируется от «это похоже на человека Икс» до «это ведет себя как человек Икс с течением времени».

По мере развития этих возможностей разрыв в восприятии между синтетическими и аутентичными человеческими средами будет продолжать сокращаться. Значительная линия защиты будет отклонена от человеческого суждения. Вместо этого это будет зависеть от защиты на уровне инфраструктуры. К ним относятся безопасные источники, такие как средства массовой информации с криптографической подписью, и инструменты искусственного интеллекта, использующие открытые стандарты, такие как предложенный Коалицией для определения происхождения и подлинности контента.

«Простого пристального взгляда на пиксели уже будет недостаточно», — заключает эксперт-криминалист.

Редактор: AndreyEx